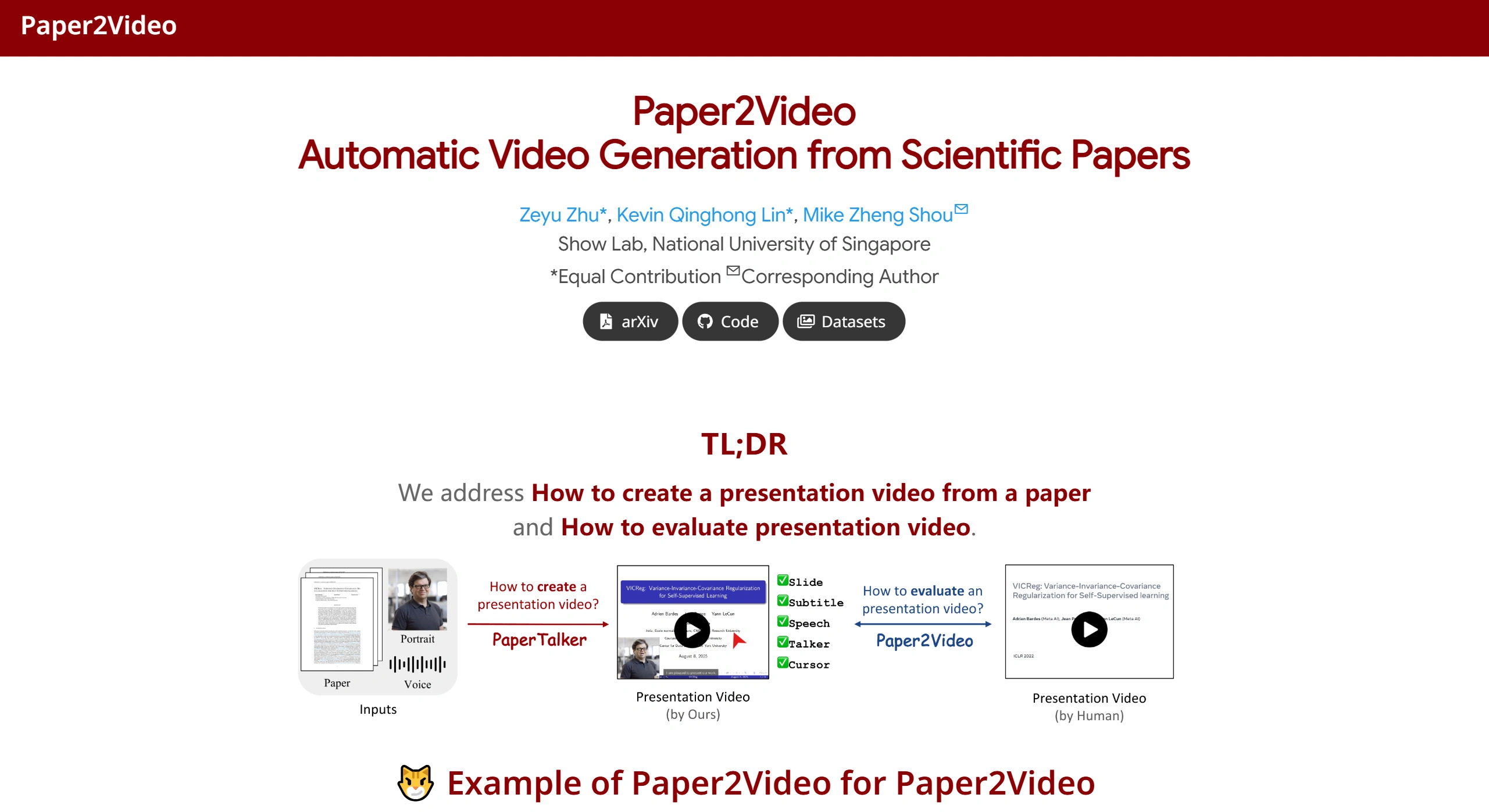

Paper2Video 是新加坡国立大学 Show Lab 团队的开源项目。它能自动把学术论文转成完整的演示视频。项目用 PaperTalker 多智能体框架,自动完成内容提取、做幻灯片、合成语音、生成虚拟演讲者这些步骤。以前要几个小时的手动工作,现在可以自动完成。

Paper2Video工具主要解决两个问题:

怎么做学术演示视频 — 用 PaperTalker 多智能体框架

怎么评价视频质量 — 用 Paper2Video 基准测试和评估指标

✨ 功能特征

| 功能 | 说明 |

|---|---|

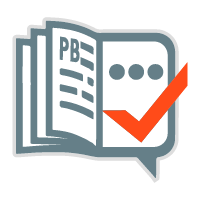

| 🎨 智能幻灯片生成 | 从 LaTeX 论文源码提取核心内容,自动生成 Beamer 格式幻灯片。用树搜索算法优化布局,解决图文溢出等排版问题 |

| 📝 字幕与语音合成 | 根据幻灯片内容生成演讲稿,用 TTS 技术合成语音,生成时间戳精确对齐的字幕 |

| 🖱️ 光标轨迹模拟 | 用 WhisperX 和 UI-TARS 技术,自动生成与演讲同步的鼠标移动和点击轨迹,引导观众注意力 |

| 👤 虚拟演讲者生成 | 只要一张正面头像照片和约10秒语音样本,就能生成口型同步的虚拟数字人视频 |

| ⚡ 并行处理加速 | 支持按幻灯片页并行生成,处理速度比传统方式快约6倍 |

| 🔄 双模式运行 | 有完整模式(含虚拟演讲者)和快速模式(不含虚拟演讲者)两种选择,适应不同硬件条件 |

🎯 应用场景

学术会议报告 — 快速生成线上会议分享视频或会议提交材料,省去手动做幻灯片和录制的时间

研究成果传播 — 把复杂论文转成易懂的短视频,发到社交媒体或视频平台,扩大研究影响力

教育与课程材料 — 把经典或最新学术论文转成教学视频,帮助学生直观理解前沿科学知识

论文预讲与排练 — 正式答辩前生成预览视频,检查逻辑流程、时间控制和视觉效果

学术报告与公开讲座 — 方便研究人员快速做内部汇报或公开讲座视频

🛠️ 使用方法

1. 环境准备

# 克隆项目并进入目录 git clone https://github.com/showlab/Paper2Video.git cd Paper2Video/src # 创建并激活 Conda 环境 conda create -n p2v python=3.10 conda activate p2v # 安装依赖和 LaTeX 编译器 pip install -r requirements.txt conda install -c conda-forge tectonic

2. 虚拟演讲者环境(可选)

如果需要生成虚拟演讲者,要单独配置 Hallo2 环境:

cd Paper2Video git clone https://github.com/fudan-generative-vision/hallo2.git cd hallo2 conda create -n hallo python=3.10 conda activate hallo pip install -r requirements.txt # 记录 Python 路径供后续使用 which python

3. 配置大语言模型 API

export GEMINI_API_KEY="你的Gemini密钥" export OPENAI_API_KEY="你的OpenAI密钥"

4. 运行生成

快速模式(不含虚拟演讲者):

python pipeline_light.py \ --model_name_t gpt-4.1 \ --model_name_v gpt-4.1 \ --result_dir /path/to/output \ --paper_latex_root /path/to/latex_proj \ --ref_img /path/to/ref_img.png \ --ref_audio /path/to/ref_audio.wav \ --gpu_list [0,1,2,3,4,5,6,7]

完整模式(含虚拟演讲者):

python pipeline.py \ --model_name_t gpt-4.1 \ --model_name_v gpt-4.1 \ --model_name_talking hallo2 \ --result_dir /path/to/output \ --paper_latex_root /path/to/latex_proj \ --ref_img /path/to/ref_img.png \ --ref_audio /path/to/ref_audio.wav \ --talking_head_env /path/to/hallo2_env \ --gpu_list [0,1,2,3,4,5,6,7]

输入要求:

📄 论文:LaTeX 格式的完整论文工程

🖼️ 参考图片:方形正面人像照片(用于生成虚拟演讲者)

🎵 参考音频:约10秒的语音样本(用于克隆声音风格)

❓ 常见问题

硬件要求是什么?官方推荐 NVIDIA A6000 GPU(48GB显存) 或更高配置。普通电脑或笔记本可能跑不了完整流程,特别是虚拟演讲者渲染部分

不想露脸可以用吗? 可以。用 pipeline_light.py 脚本跑快速模式,能生成包含幻灯片、配音、字幕和鼠标轨迹的视频,但没有虚拟演讲者画面,对计算资源要求也低

支持哪些大语言模型? 支持 GPT-4.1、Gemini 2.5-Pro 等商业 API,也支持本地部署的开源模型如 Qwen 系列

生成视频的质量怎么样? 实验表明,PaperTalker 在 PresentQuiz 指标上准确率 84.2%,比人类制作视频高 10%。IP Memory 指标得分高 50%。用户研究显示其质量与人工视频相当

怎么评价生成视频的质量? 项目提了四项评估指标:Meta Similarity(元相似度)、PresentArena(观众偏好)、PresentQuiz(知识测验)、IP Memory(作者记忆度)

视频生成不自然怎么调?检查参考音频质量(10秒最佳),或者用 --ref_text 参数加风格提示文本调整字幕风格。

相关资源

项目主页:https://showlab.github.io/Paper2Video/

GitHub 仓库:https://github.com/showlab/Paper2Video

论文 arXiv:https://arxiv.org/pdf/2510.05096

Paper2Video 降低了学术视频制作门槛。研究者可以把更多时间花在核心研究工作上。

简历求职

简历求职 效率办公

效率办公 文档转换

文档转换 图片处理

图片处理 视频工具

视频工具 AI+科研

AI+科研 AI智能体

AI智能体 休闲游戏

休闲游戏 Ai+学习

Ai+学习  英语学习

英语学习  考研考公

考研考公  出国留学

出国留学  资格考试

资格考试  学习平台

学习平台  宝藏网站

宝藏网站