SurveyForge是什么?

SurveyForge 是一款由上海人工智能实验室联合复旦大学、上海交通大学等多家单位共同开发的AI工具,专门用于自动生成高质量的学术综述论文。其相关研究已被 ACL 2025 主会议接收。

功能亮点

高效生成:SurveyForge 能在短短 10 分钟内生成一篇约 6 万字的综述论文,成本不到 3.6 元人民币。

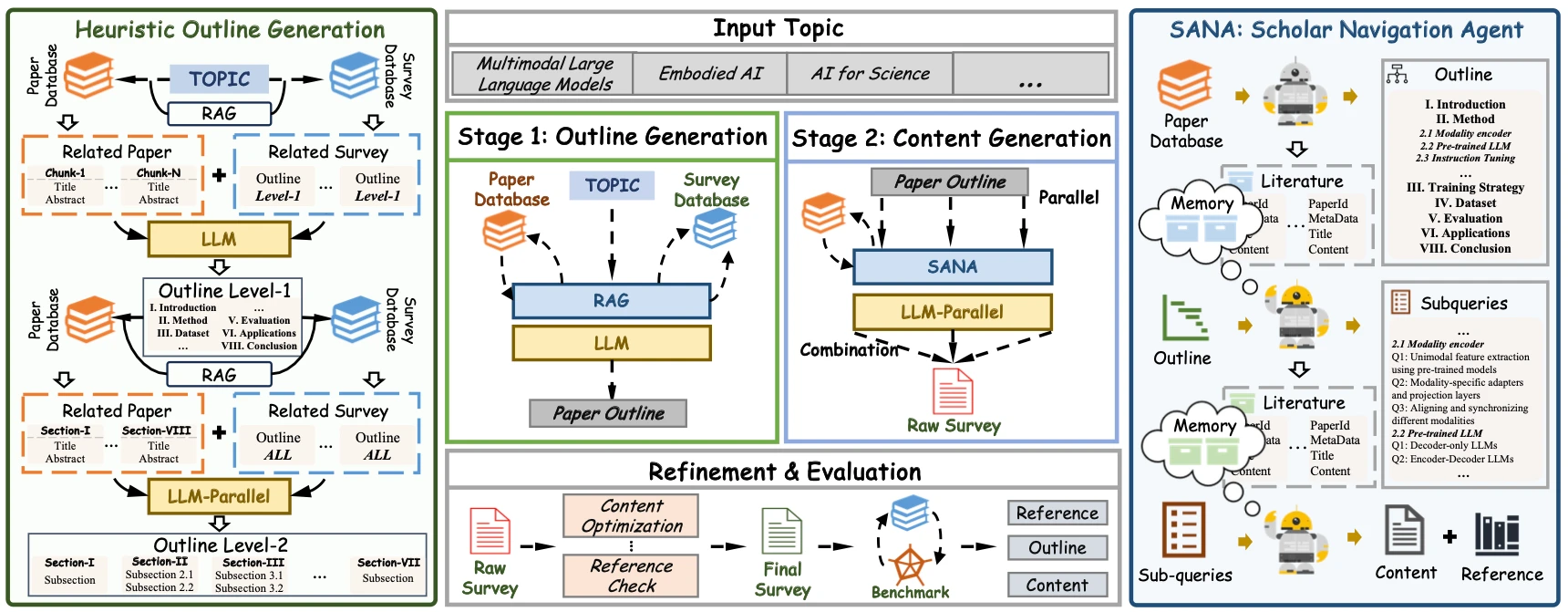

两阶段生成框架:它采用了“大纲生成”和“内容生成”两阶段的设计。首先,通过对人工撰写的综述大纲和领域相关文献的分析,生成高质量的大纲;然后,利用检索到的高质量论文生成并优化内容。

高质量文献引用:借助时间感知重排序引擎,SurveyForge 能够将检索到的文献按发表时间分组,并按照引用数进行筛选,确保引用的文献既有经典权威性,又紧跟学术前沿。

多维度评估:为了评估生成的综述质量,开发团队构建了 SurveyBench 基准,包含 100 篇人工撰写的综述论文,从参考文献质量、大纲质量和内容质量三个维度进行全面评估。

技术优势

双数据库协同驱动:SurveyForge 结合了约 60 万篇计算机科学领域的研究论文数据库和 2 万篇综述文章的大纲数据库。通过跨数据库的知识融合,它能够生成逻辑清晰、层次分明的大纲。

学者导航代理(SANA):这一模块确保了文献检索过程中的上下文连贯性,从而提高文献的相关性和质量。

并行生成与协调机制:各个章节可以并行生成内容,通过共享记忆系统确保主题的一致性,最后进行精炼优化,形成一篇连贯的整体。

应用场景

初学者入门:对于刚刚踏入某一领域的研究者来说,SurveyForge 是一个快速获取领域全景的有效工具。

跨学科研究:它能够降低跨学科知识整合的门槛,帮助研究者更高效地开展跨学科研究。

资深研究者:对于经验丰富的研究者,SurveyForge 可以作为文献调研的得力助手,提升研究效率。

使用方法

生成论文:用户可以通过邮件或在 GitHub 仓库中提交问题来请求生成论文,整个过程大约需要 10 分钟。

评估论文:使用 SurveyBench 进行评估,用户可以通过运行相关脚本完成评估操作。

项目链接

GitHub:https://github.com/Alpha-Innovator/SurveyForge

评估数据集:https://huggingface.co/datasets/U4R/SurveyBench

简历求职

简历求职 效率办公

效率办公 文档转换

文档转换 图片处理

图片处理 视频工具

视频工具 AI+科研

AI+科研 AI智能体

AI智能体 休闲游戏

休闲游戏 Ai+学习

Ai+学习  英语学习

英语学习  考研考公

考研考公  出国留学

出国留学  资格考试

资格考试  学习平台

学习平台  宝藏网站

宝藏网站